据雷介绍,2018年全球人工智能与机器人峰会在深圳举行。峰会由中国计算机学会主办,雷和香港中文大学协办。

会议吸引了来自人工智能行业的2500多人,包括来自世界各地在人工智能领域享有盛誉的140名演讲者和圆桌嘉宾。

在会议第二天的“计算机视觉特别会议”上,2011、2022总裁全龙、微软亚洲研究院副院长张、飞利浦中国CTO、迪法恩科技首席科学家、7项大奖获得者田杰、最高国际医学影像分析会议MICCAI 2019联席主席沈丁刚等发表了重要讲话。

其中,上汤科技联合创始人、香港中汤联合实验室主任华教授分享了在计算机视觉研究方面的新探索。

林大华在讲话中对计算机视觉这几年的发展进行了总结、反思和展望。他说,深度学习开启了计算机视觉发展的黄金时代。近年来,计算机视觉取得了很大的进步,但这种发展是广泛的,堆积了大量的数据和计算资源。这种发展模式能否持续,值得深思。

他指出,随着计算机视觉精度的巅峰,行业应该寻求更多的发展水平。商汤的主要尝试有三:一是提高计算资源的效率;二是降低数据资源的标注成本;第三,提高人工智能的质量。

以下是林大华演讲的全部内容。雷锋。com在不改变初衷的情况下对其进行了组织和编辑:

很荣幸与大家分享香港中商堂联合实验室过去几年的工作。刚才几位发言人从商业角度做了精彩的分享。相信大家都受益匪浅。我的发言可能有点不一样。我是商汤的联合创始人,但不直接参与商汤的业务运营。如果大家都关心商汤什么时候上市,恐怕我回答不了。

但是我可以告诉你,商汤公司不是一天建成的。它的成功不仅取决于过去三年半的努力,还取决于实验室18年积累的原始技术。这个实验室做的事情决定的不是商汤今天拿出来盈利的东西;但商汤要想成为一家伟大的科技公司,未来3年、5年甚至10年应该往哪个方向发展。

人工智能发展迅速,但发展广泛

下图想必大家都很熟悉。

在过去的八年里,计算机视觉取得了突破,其中最重要的技术进步是引入了深度学习。这个领域有一个非常高水平的竞争——ImageNet。2012年之前,这个比赛的识别错误率比较高。2012年引入深度学习技术后,计算机视觉经历了四年的黄金时期。在四年的黄金时期,Image Net比赛的识别错误率从20%下降到近3%,然后停滞不前,直到去年比赛结束。

所以,我想问一个问题:深度学习确实推动了计算机视觉在近几年的黄金时期有了长足的进步和突破,但这是否意味着计算机视觉发展到今天的水平已经走到了尽头?在今天的基础上展望3年、5年、10年,未来应该向哪个方向学习?这是我们实验室和商汤一直在思考的问题。

人工智能这几年的成功不是偶然的,它不仅是算法发展的结果,也是很多因素历史趋同的结果。第一个因素是数据。我们有大量的数据。第二个因素是GPU的发展,推动计算能力大幅跃升。在数据和计算能力的基础上,算法的进步带来了今天人工智能的成功和它在许多应用场景中的落地。我想传达给你的信息是,虽然我们看到了人工智能的成功和算法的巨大进步,但人工智能不是魔法,从某种意义上说,它是由巨大的数据量和强大的计算能力支撑的性能进步。

回顾人工智能这几年的辉煌发展,可以看出从某种意义上来说是非常广泛的发展。每个人都在追求准确性和性能,中国公司在所有竞争名单中排名前三。虽然我们在很多榜单上,但是行业的利润基本都是由制定标准的公司赚取的。这种发展模式可持续吗?这个值得深思。

除了准确性,我们还必须追求效率、成本和质量

回顾这几年深度学习或者人工智能的发展,我觉得我们还有很多事情要做,还有很长的路要走。

接下来和大家分享一下我的思考方向:第一,学习效率,我们是否充分利用现有的计算资源?二、如何解决数据和标注的成本问题?第三,虽然我们在列表中达到了99.9%的准确率,但是这样训练出来的模型真的能满足我们生活或者社会生产的需要吗?这些都是我们需要解决的问题,以促进人工智能更好更快的发展和落地。

下面,我先详细说说第一个方面——效率。

前面说过,我们走的是粗放式的发展路线,依靠积累数据和计算资源来换取高性能,这是资源的竞争而不是效率的竞争。在行业发展的今天,标准制定公司赚取了大部分利润。面对这种情况,未来应该如何发展?要回答这个问题,首先要复习一下现在的机型和技术模式,看看有没有优化空的房间。优化的原理很简单,就是在刀刃上用好钢。

举例说明。两年前开始进入视频领域,视频对效率的要求非常高,因为视频的数据量巨大,一秒24帧,一分钟1500帧,相当于一个中型数据库。用传统的图像处理方式处理视频显然是不合适的。

2013年和2014年的视频分析方法大多简单粗暴:取出每一帧,运行一个卷积网络,最后结合起来判断。虽然计算资源在过去几年发展迅速,但GPU内存仍然有限。如果每一层放入CNN,GPU内存只能容纳10帧到20帧左右,一秒钟的视频占用GPU,无法长时间分析视频,是一种非常低效的模式。

我们知道,视频相邻帧之间的重复率非常高。如果每一帧都运行一次,实际上浪费了大量的计算资源。意识到这种重复计算模式的低效率,我们把采样方式改为稀疏采样:不管视频有多长,都分成等长的段落,每个段落只占用一帧。这样可以及时完整的覆盖视频,分析结果自然具有更高的可靠性和准确性。有了这个网络,我们获得了2016年的ActivityNet冠军。现在大多数视频分析架构都采用了这种稀疏采样方法。

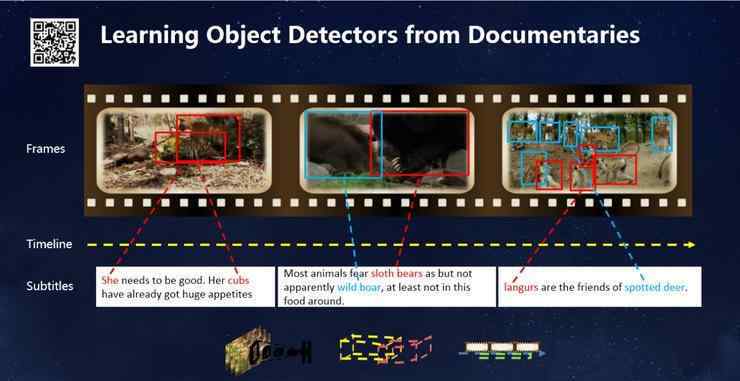

之后,我们进一步拓展研究领域,不仅要做视频理解,还要做视频中的物体检测。这就带来了新的挑战:在做分类识别之前,可以对每一段进行分段,大致了解;但是物体检测做不到这一点,每一帧的物体位置都必须输出,不能在时间上稀疏。

下图是我们在2016年ImageNet大赛中获得视频对象检测项目称号的网络。这个网络的做法基本上是把每个帧的特征拿出来,判断其类型是什么,调整对象帧的位置,然后串在一起。每一帧都需要处理。当时最强大的GPU每秒只能处理几帧,需要大量的GPU来训练这个网络。

我们希望将这样的技术应用到实际场景中,得到一个实时的目标检测框架。如果按照刚才的方法处理每一帧,需要140毫秒,绝对没有办法达到实时。但是中间那帧呢,如果我们稀疏的取,比如说每20帧?

你可能会想到插值插入,但是我们发现这种方法对精度影响很大。每10帧拍一次,两者的精度差别很大。在新提出的方法中,我们使用了帧之间的关系,通过一个便宜得多的网络模块在帧之间传输信息只需要5毫秒,可以很好地保持检测精度。这样,在我们再次改变视频分析的路径后,整体成本大大降低。没有什么新鲜的,网络都是那些网络,只是我们重新规划了视频分析的计算路径,重新设计了整个框架。

可以看看结果。以上是7毫秒逐帧处理的,这是我们在2016年比赛中使用的网络。后来改进后超过每秒62帧,由于使用了多帧之间的相关性,其结果更可靠更平滑。