据雷介绍,2018年全球人工智能与机器人峰会在深圳举行。峰会由中国计算机学会主办,雷和香港中文大学协办。

会议吸引了来自人工智能行业的2500多人,包括来自世界各地在人工智能领域享有盛誉的140名演讲者和圆桌嘉宾。

在会议第二天的“计算机视觉特别会议”上,2011、2022总裁全龙、微软亚洲研究院副院长张、飞利浦中国CTO、迪法恩科技首席科学家、7项大奖获得者田杰、最高国际医学影像分析会议MICCAI 2019联席主席沈丁刚等发表了重要讲话。

其中,上汤科技联合创始人、香港中汤联合实验室主任华教授分享了在计算机视觉研究方面的新探索。

林大华在讲话中对计算机视觉这几年的发展进行了总结、反思和展望。他说,深度学习开启了计算机视觉发展的黄金时代。近年来,计算机视觉取得了很大的进步,但这种发展是广泛的,堆积了大量的数据和计算资源。这种发展模式能否持续,值得深思。

他指出,随着计算机视觉精度的巅峰,行业应该寻求更多的发展水平。商汤的主要尝试有三:一是提高计算资源的效率;二是降低数据资源的标注成本;第三,提高人工智能的质量。

以下是林大华演讲的全部内容。雷锋。com在不改变初衷的情况下对其进行了组织和编辑:

很荣幸与大家分享香港中商堂联合实验室过去几年的工作。刚才几位发言人从商业角度做了精彩的分享。相信大家都受益匪浅。我的发言可能有点不一样。我是商汤的联合创始人,但不直接参与商汤的业务运营。如果大家都关心商汤什么时候上市,恐怕我回答不了。

但是我可以告诉你,商汤公司不是一天建成的。它的成功不仅取决于过去三年半的努力,还取决于实验室18年积累的原始技术。这个实验室做的事情决定的不是商汤今天拿出来盈利的东西;但商汤要想成为一家伟大的科技公司,未来3年、5年甚至10年应该往哪个方向发展。

人工智能发展迅速,但发展广泛

下图想必大家都很熟悉。

在过去的八年里,计算机视觉取得了突破,其中最重要的技术进步是引入了深度学习。这个领域有一个非常高水平的竞争——ImageNet。2012年之前,这个比赛的识别错误率比较高。2012年引入深度学习技术后,计算机视觉经历了四年的黄金时期。在四年的黄金时期,Image Net比赛的识别错误率从20%下降到近3%,然后停滞不前,直到去年比赛结束。

所以,我想问一个问题:深度学习确实推动了计算机视觉在近几年的黄金时期有了长足的进步和突破,但这是否意味着计算机视觉发展到今天的水平已经走到了尽头?在今天的基础上展望3年、5年、10年,未来应该向哪个方向学习?这是我们实验室和商汤一直在思考的问题。

人工智能这几年的成功不是偶然的,它不仅是算法发展的结果,也是很多因素历史趋同的结果。第一个因素是数据。我们有大量的数据。第二个因素是GPU的发展,推动计算能力大幅跃升。在数据和计算能力的基础上,算法的进步带来了今天人工智能的成功和它在许多应用场景中的落地。我想传达给你的信息是,虽然我们看到了人工智能的成功和算法的巨大进步,但人工智能不是魔法,从某种意义上说,它是由巨大的数据量和强大的计算能力支撑的性能进步。

回顾人工智能这几年的辉煌发展,可以看出从某种意义上来说是非常广泛的发展。每个人都在追求准确性和性能,中国公司在所有竞争名单中排名前三。虽然我们在很多榜单上,但是行业的利润基本都是由制定标准的公司赚取的。这种发展模式可持续吗?这个值得深思。

除了准确性,我们还必须追求效率、成本和质量

回顾这几年深度学习或者人工智能的发展,我觉得我们还有很多事情要做,还有很长的路要走。

接下来和大家分享一下我的思考方向:第一,学习效率,我们是否充分利用现有的计算资源?二、如何解决数据和标注的成本问题?第三,虽然我们在列表中达到了99.9%的准确率,但是这样训练出来的模型真的能满足我们生活或者社会生产的需要吗?这些都是我们需要解决的问题,以促进人工智能更好更快的发展和落地。

下面,我先详细说说第一个方面——效率。

前面说过,我们走的是粗放式的发展路线,依靠积累数据和计算资源来换取高性能,这是资源的竞争而不是效率的竞争。在行业发展的今天,标准制定公司赚取了大部分利润。面对这种情况,未来应该如何发展?要回答这个问题,首先要复习一下现在的机型和技术模式,看看有没有优化空的房间。优化的原理很简单,就是在刀刃上用好钢。

举例说明。两年前开始进入视频领域,视频对效率的要求非常高,因为视频的数据量巨大,一秒24帧,一分钟1500帧,相当于一个中型数据库。用传统的图像处理方式处理视频显然是不合适的。

2013年和2014年的视频分析方法大多简单粗暴:取出每一帧,运行一个卷积网络,最后结合起来判断。虽然计算资源在过去几年发展迅速,但GPU内存仍然有限。如果每一层放入CNN,GPU内存只能容纳10帧到20帧左右,一秒钟的视频占用GPU,无法长时间分析视频,是一种非常低效的模式。

我们知道,视频相邻帧之间的重复率非常高。如果每一帧都运行一次,实际上浪费了大量的计算资源。意识到这种重复计算模式的低效率,我们把采样方式改为稀疏采样:不管视频有多长,都分成等长的段落,每个段落只占用一帧。这样可以及时完整的覆盖视频,分析结果自然具有更高的可靠性和准确性。有了这个网络,我们获得了2016年的ActivityNet冠军。现在大多数视频分析架构都采用了这种稀疏采样方法。

之后,我们进一步拓展研究领域,不仅要做视频理解,还要做视频中的物体检测。这就带来了新的挑战:在做分类识别之前,可以对每一段进行分段,大致了解;但是物体检测做不到这一点,每一帧的物体位置都必须输出,不能在时间上稀疏。

下图是我们在2016年ImageNet大赛中获得视频对象检测项目称号的网络。这个网络的做法基本上是把每个帧的特征拿出来,判断其类型是什么,调整对象帧的位置,然后串在一起。每一帧都需要处理。当时最强大的GPU每秒只能处理几帧,需要大量的GPU来训练这个网络。

我们希望将这样的技术应用到实际场景中,得到一个实时的目标检测框架。如果按照刚才的方法处理每一帧,需要140毫秒,绝对没有办法达到实时。但是中间那帧呢,如果我们稀疏的取,比如说每20帧?

你可能会想到插值插入,但是我们发现这种方法对精度影响很大。每10帧拍一次,两者的精度差别很大。在新提出的方法中,我们使用了帧之间的关系,通过一个便宜得多的网络模块在帧之间传输信息只需要5毫秒,可以很好地保持检测精度。这样,在我们再次改变视频分析的路径后,整体成本大大降低。没有什么新鲜的,网络都是那些网络,只是我们重新规划了视频分析的计算路径,重新设计了整个框架。

可以看看结果。以上是7毫秒逐帧处理的,这是我们在2016年比赛中使用的网络。后来改进后超过每秒62帧,由于使用了多帧之间的相关性,其结果更可靠更平滑。

商汤也在做自动驾驶,需要对驾驶场景进行自动理解和语义分割,这也是一个非常成熟的领域。但是大家都没有注意到这一点,大家都在关注分割的准确性和像素级别,没有意义。我们真的是做自动驾驶的,我们关心的是,当有人在你车前的时候,你能多快判断出有人在,然后进行紧急处理。所以在自动驾驶的场景中,判断的效率和速度非常重要。在以前的方法中,处理一帧需要100多毫秒。如果一个人出现在车前,来不及反应。

使用刚才提到的方法,我们重建了一个模型,并充分利用了帧之间的关系。我们可以将每帧的处理效率从600毫秒降低到60毫秒,大大提高这项技术对突发情况的响应速度。其实这里也用过类似的方法,技术细节就不说了。

刚才说了如何提高效率,然后又说了如何降低数据成本。

人工智能就是只有人工智能,智能只有体力劳动者那么多。人工智能繁荣的今天,我们一定不能忘记默默致力于其背后的成千上万的数据标注者。今天商汤日夜标注数据的标注人员近800人,一些大公司的标注人员上万人,这也是一笔巨大的成本。

如何降低数据标注的成本,是我们每天都在思考的问题。既然很多东西不能手动标注,那我们能不能改变思维,去寻找数据和场景中包含的标注信息?

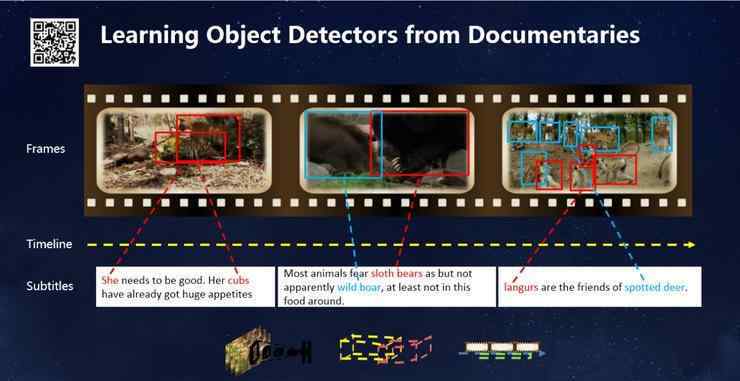

下图是去年在CVPR发表的一项研究结果,它尝试了一种全新的学习方式。以前图片的贴标成本很高。每张图片不仅要贴标签,还要给目标对象加边框。例如,学习识别动物需要手工标记动物。我们小的时候,学习识别动物的过程并不是这样。我们不是老师给我一张裱好的图学,而是看《动物世界》学的。这促使我有了一个想法:模型可以通过阅读《动物世界》来识别所有动物吗?纪录片里有字幕。如果和视觉场景联系起来,模型能自动学习吗?因此,我们设计了一个框架来建立视觉和文本之间的关系,最终得到如下图所示的结果。

下图展示了几十种动物,我们可以通过阅读《动物世界》和《国家地理》来准确识别,无需任何标签或人工干预。

此外,人脸识别还需要标记大量的人脸数据。有一些数据,比如我们的家庭相册,没有标注,但是包含了很多信息。

请看下图。这是电影《泰坦尼克号》中的一些场景。左上角的场景,光看脸很难认出这两个人是谁。看右上角的第一个场景,可以认出左边的人是Rose,但是右边穿西装的人还是看不清楚。如果能识别出电影背后的场景,我们会发现杰克和罗斯经常出现在同一个场景中。基于这些社交信息,我们可以推断出穿黑色西装的人可能是杰克。这样,我们就可以在不标注人脸的情况下获得大量有意义的数据。

我们也将这一技术应用到视频监控领域:在深圳,一个人从一条街走到另一条街时,人脸图像往往会发生变化,但只要我们能跟踪到他的轨迹,就能判断捕获的人脸属于同一个人,这对于训练人脸模型是非常有价值的信息。这项成果刚刚发表在CVPR的报纸上。

最后说说质量。

人工智能的最终目的是给生活带来便利,提高生活质量。但是近几年来,人工智能的发展似乎进入了一个误区,人工智能的好坏与准确性挂钩。我认为人工智能的质量是多方面、多层次的,而不仅仅是准确性。

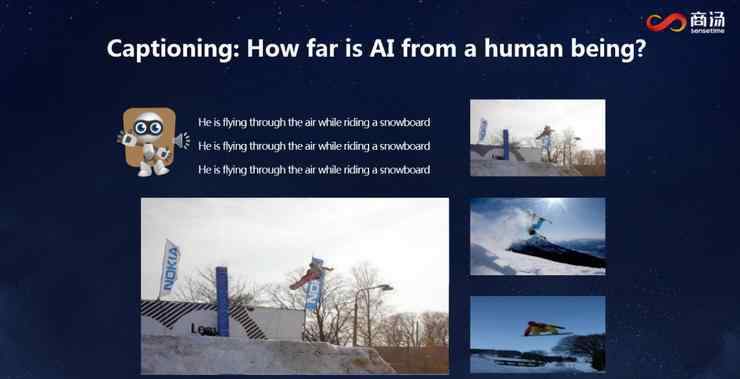

我举几个例子吧。“与图片对话”是近年来的一个热门领域,即将图片展示给计算机,使其自动生成描述。下图是我们最新方法的结果。

我们发现我们给最好的模特看了三张不同的图片,它会说同一句话,在标准测试中得分很高,没有任何问题。但是当我们把它和人类的描述放在一起,我们发现人类并不是这样说话的。人类在描述一幅画面时,即使面对同一幅画面,不同的人的表情也是不同的。也就是说,人工智能在追求识别精度的同时,忽略了其他品质,包括语言的自然性和图片的特点。

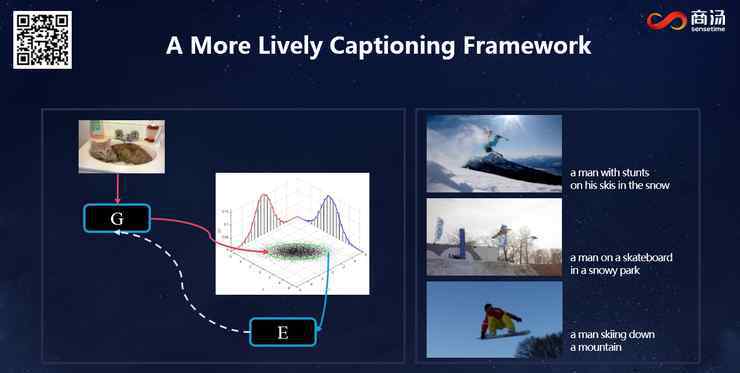

为了解决这个问题,我们去年提出了一个新方法。它不再把内容描述看作翻译问题,而是一个概率抽样问题。它承认描述的多样性,当每个人看到同样的画面时,他们会说不同的话。我们希望学习这个采样过程。这个模型的细节可以参考相关论文。这里只展示了结果:对于同样的三张图片,模型生成了三个更生动、更能描述图片特征的句子。

我们来传播延伸一下:AI模型既然能生成一句话,那它是否也能生成一个动作?下图是我们的最新研究。很多AI公司都在做这方面的研究,让AI产生生动的舞蹈。下面是一些简单的动作,是电脑自动生成的,不是程序描述的。

最后对之前的分享做一个总结。在过去的几年里,人工智能和深度学习都取得了快速的进步,这不仅体现在标准数据集上准确性的提高,还体现在业务场景的落地上。但是回过头来看这段发展,我们发现在向精准大踏步前进的过程中,我们忘记了很多东西。我们的效率够高吗?我们是否透支了数据显示的成本?我们训练的模型能满足现实生活的质量要求吗?从这些角度来看,我觉得我们才刚刚起步。虽然我们的实验室和世界上许多其他实验室取得了一些重要的进展,但我们仍然处于初级阶段,还有很长的路要走。以上,希望与大家分享,谢谢!

以下是问答环节的重点:

问题:想知道商汤在基础研发和产品落地方面的资源如何配置?

林大华:这个问题很好。我认为这不是一个简单的分配问题,而是一个正循环过程。我们一线的同事会接触到很多具体的落地场景,从场景中发现问题。我前面提到的很多问题都是他们从落地现场发现的,可以为学术界提供不同的视角。一线同事由于产品落地的压力无法解决这些问题,这些问题会转移到实验室进行长期的技术讨论。讨论的结果最终会反馈给产品。这使得商汤的技术领先和进步。我们不仅与朋友竞争数据和计算资源,而且拥有技术领先的视角。这就是我们基础研究部门和一线产品部门的互动关系。

问:cv厂商与传统安全厂商的技术合作是趋势吗?合作模式是“AI+安全”还是“安全+AI”?

林大华:传统安防厂商提供集成解决方案和摄像头。以前他们不涉及AI技术。商汤从实验室发展而来,从学术起步,然后慢慢落地。现在cv厂商和传统安全厂商都在走向技术落地,大家相聚。因此,我认为传统安全厂商与掌握先进AI技术的公司和实验室深度合作是一个重要趋势。

但是中间有风险:一边是从应用端往前走,一边是从技术端往后退,大家都想在技术上占领制高点。这就需要大家建立一个信任共赢的机制,只有这样合作才能长久。

问题:在深度学习的流行环境下,传统的机器学习方法有没有研究价值?

林大华:我经常在学术会议和公开演讲中被问到这个问题。我认为我们不应该把深度学习视为一种普遍的方法。从某种意义上说,它是一种新的研究模式。当我们最终面对场景和应用的时候,还是要针对问题提出一套解决方案。深度学习的建模能力很强,但也有不足之处。例如,我们面临一个复杂的问题,涉及不同设备之间的交互和多个变量的建模。也许传统的概率学习和随机过程可以发挥作用。如果与深度学习相结合,可以实现性能上的突破。

在回香港教书之前,我花了很长时间学习统计学习和概率图模型。当时概率图模型很压抑。虽然它有许多数据库,但不能满足数据要求。其实是一个很好的模型,让我们可以对世界进行深度建模。通过深度学习,它们可以一起用于将一些变量的简单假设(如高斯分布)切换到使用深度网络构建的模型。这样,传统的模型将被升级和迭代,为我们的特定问题和应用提供更有效的解决方案。所以,它们不是替代关系,而是组合关系。近年来,许多研究表明了这一趋势,用深度学习武装传统的思想和方法,最终取得了良好的效果。

问题:近年来,图像领域的深度学习遇到了一些瓶颈,短期内没有突破。从学术角度怎么看?

林大华:其实我整个演讲都在讲。我认为我们应该扩大我们的追求范围。机器学习的目标不仅仅是数据,还有很多值得探索的研究方面。比如以前商汤只关注人脸识别的准确性,后来我们发现很多问题,包括时间成本、数据标注、可靠性、模型压缩等等。这些以前的研究都没有涉及到,现在已经成为一个非常大很有前景的领域。比如模型压缩以前没有这个要求,但是当我们发现原来的方法在实际应用中不能解决问题的时候,就想到了是否可以压缩模型。这些来自现实的想法开辟了近年来一些新的研究方向。单从准确率来看,目前已经达到了很高的水平,没有太多的空可以更进一步。但是在具体应用上还是有很多新的挑战,每一个都是一个研究方向,还有很多研究空。

1.《林达华 商汤科技联合创始人林达华:摒弃粗放式的计算机视觉研究,我谈三点思考 | CCF-GAIR 2018》援引自互联网,旨在传递更多网络信息知识,仅代表作者本人观点,与本网站无关,侵删请联系页脚下方联系方式。

2.《林达华 商汤科技联合创始人林达华:摒弃粗放式的计算机视觉研究,我谈三点思考 | CCF-GAIR 2018》仅供读者参考,本网站未对该内容进行证实,对其原创性、真实性、完整性、及时性不作任何保证。

3.文章转载时请保留本站内容来源地址,https://www.lu-xu.com/shehui/1014362.html