zero最近怎么不直播了相关介绍,2014年,b站初次是因侵犯爱奇艺购买的日本新番动画版权,被爱奇艺搞上法庭。开始被媒体所提。 随后2015年b站开始版权化,再加上中国文化...

在游戏中按Esc键显示功能菜单,然后同时按下U+J键(或ctrl+alt+u+j),要求输入密码,此时输入“ ”即开始作弊模式。此后按F10键会显示功能开关屏幕,说明秘籍开启成功。这个...

1dnf命运的抉择,进图选择月亮,可以保命。 2,暴击先点满,到90就差不多了,因为有装备可以直接100%暴击, 3,天堂舞姬这个装备一定要选,很好用。 4,魔神的话,大蹦和浴血之怒,看哪...

选择当地主来玩玩看,可以打开显示AI手牌功能,更容易观察AI决策过程。另外可以设置AI考虑时间,默认是3秒。

有时可以看到AI并不是简单的选择当前胜率最高的打法,而是有更全局的考虑。

斗地主对AI来说,很难

从博弈论的角度看,斗地主是“不完全信息博弈”。

围棋是所有棋子都摆在棋盘上,对弈双方都能看到的完全信息博弈。

而斗地主每个玩家都看不到其他人的手牌,对于AI来说更有挑战性。

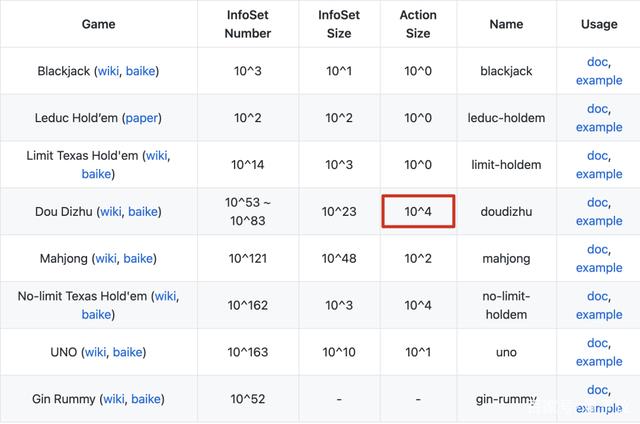

在棋牌类游戏中,虽然斗地主的信息集的大小和数量不如麻将,但行动空间有10^4,与德州扑克相当,而大多数强化学习模型只能处理很小的行动空间。

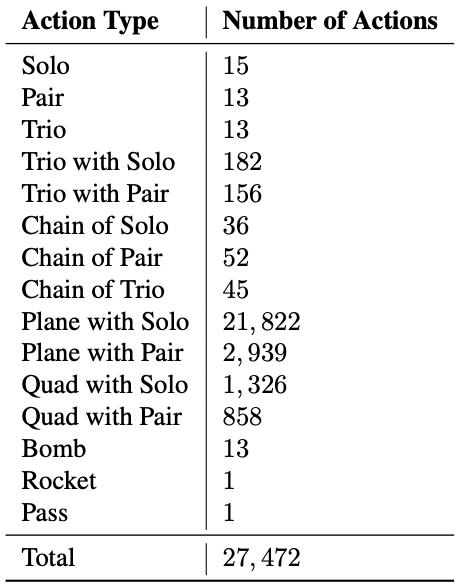

斗地主的所有牌型总共有27472种可能。

像下图的手牌就有391种打法。

且斗地主的行动不容易被抽象化,使搜索的计算成本很高,像Deep Q-Learning和A3C等强化学习模型都只有不到20%的胜率。

另外作为不对称游戏,几个农民要在沟通手段有限的情况下合作并与地主对抗。

像扑克游戏中最流行的“反事实后悔最小化”(Counterfactual Regret Minimization)算法,就不擅长对这种竞争和合作建模。

全局、农民和地主网络并行学习

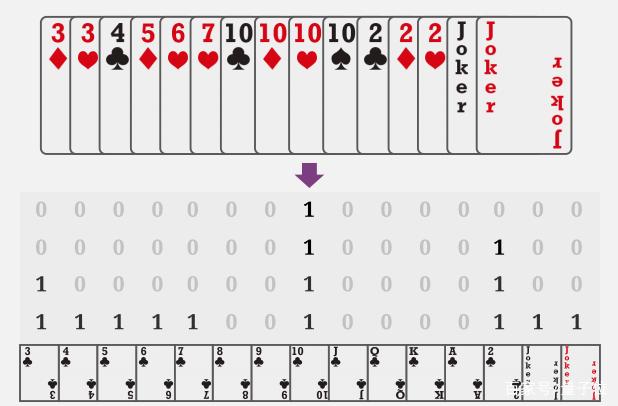

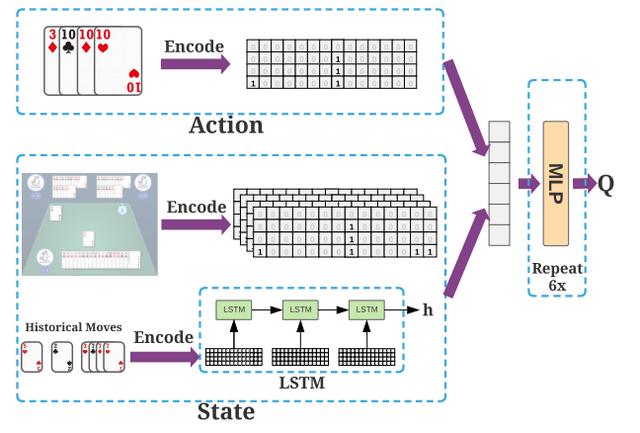

首先将手牌状态编码成4x15的独热(one-hot)矩阵,也就是15种牌每种最多能拿到4张。

DouZero是在Deep Q-Learning的基础上进行改进。

使用LSTM(长短期记忆神经网络)编码历史出牌,独热矩阵编码预测的牌局和当前手牌,最终用6层,隐藏层维度为512的MLP(多层感知机)算出Q值,得出打法。

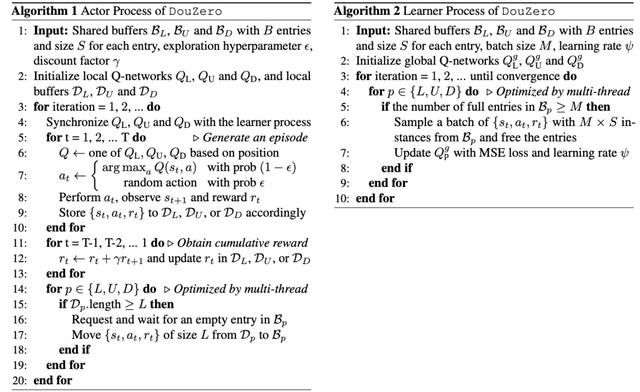

除了“学习者”全局网络以外,还用3个“角色”网络分别作为地主、地主的上家和下家进行并行学习。全局和本地网络之间通过共享缓冲区定期通信。

△学习者和角色的算法

△学习者和角色的算法DouZero在48个内核和4个1080Ti的一台服务器上训练10天击败了之前的冠军,成为最强斗地主AI。

下一步,加强AI间的协作

对于之后的工作,DouZero团队提出了几个方向:

一是尝试用ResNet等CNN网络来代替LSTM。

以及在强化学习中尝试Off-Policy学习,将目标策略和行为策略分开以提高训练效率。

最后还要明确的对农民间合作进行建模。好家伙,以后AI也会给队友倒卡布奇诺了。

蚩尤墓是为了纪念古代战神蚩尤而建造的,地址在山东省阳谷县。这里设立蚩尤陵是有原因的。据相关史料记载,蚩尤就出生在这个地方,也就是说山东阳谷是蚩尤的故乡。现在...

零重力接君。零重力是明亮的。零重力接君,零重力梁明。零重力接君,艾伦和零重力梁明。零重力接君,安迪,布里奇特和零重力梁明。网易娱乐5月25日报道,《欢乐颂2》近日热...

零重力接君。零重力是明亮的。零重力接君,零重力梁明。零重力接君,艾伦和零重力梁明。零重力接君,安迪,布里奇特和零重力梁明。网易娱乐5月25日报道,《欢乐颂2》近日热...