数据归一化的目的是将不同表示的数据归约为同一尺度,常见的尺度范围是[-1,1],[0,1]。对于神经网络和支持向量机(SVM),有必要在数据预处理中使用归一化。当然,对于一些模型来说,规范化不是必须的,比如决策树。

数据规范化方法:

1.线性标准化:

f(x) = (x - min) / (max - min)

其中min和max表示x所属区间的最小值和最大值。

特征:数据统一分类在1 ~ 0 ~ 1之间;

要求:目标值的上下限是清楚知道的。比如上图,我们假设目标值的最小值为0,最大值为1。

这种归一化方法是最常见的一种,可以用于大多数问题。例如,在图像识别中,图像的灰度值从0到255四舍五入到0到1。

二、Sigmodnormalization(Sigmodnormalization):

f(x) = 1 / (1 + exp(-ax+b))

假设a=0.1,b=5,图像为

当我们需要重点分析数据分布的中间地带,但对两端的数据不太敏感时,可以使用这种归一化方法。具体A和B根据问题调整,其中A影响上图蓝色曲线的陡度,B影响曲线的平移。

假设我们需要预测人的幸福感,影响因素有年龄、学历、收入等等。数据样本大多分布在年收入5w-40w,但也有0.5w的极低收入和1000w的极高收入,我们也发现在7w-15w范围内,人们的幸福感对收入水平非常敏感。当然,在一些简单的处理中,可以设置一个区间范围,比如[1w,100w],然后小于1w的视为1w,大于100w的视为100w。不过这个处理比较简单粗暴。为了不消除极端数据的影响,充分考虑中间敏感区间,可以使用Sigmod归一化方法,有效扩大中间数据的差异。

与这个想法相似的是反正切函数的归一化:

f(x) = atan(ax-b) / PI

其中PI为pi 3.14159...

特点:数据按“平均敏感度”分类在1-0之间;

要求:目标值的上下界不需要明确知道,对两端的数据值不敏感,对中间部分的数据值敏感。

三、Z分归一化:

f(x) = (x - q) / s

其中q为原始数据的均值x,s为原始数据的标准差。归一化数据符合正态分布,均值为0,标准差为1。

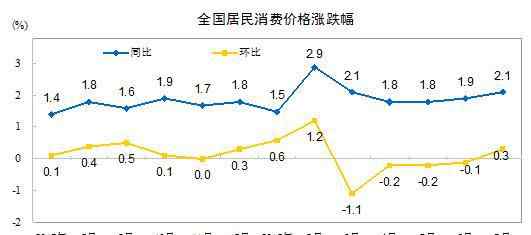

Z-score表示原始数据偏离均值的距离,距离测量的标准是标准方差。这种归一化方法要求原始数据的分布可以近似为高斯分布,否则归一化效果不好。Z分的数据分布如下图所示:

对于大量数据,68.26%将归一化为[-1,1],95.44%归一化为[-2,2],99%归一化为[-3,3]。

特点:根据数据值的分布,归一化分布概率。

要求:原始数据至少近似呈现正态分布。

1.《归一 走向人工智能 —— 数据预处理之归一化》援引自互联网,旨在传递更多网络信息知识,仅代表作者本人观点,与本网站无关,侵删请联系页脚下方联系方式。

2.《归一 走向人工智能 —— 数据预处理之归一化》仅供读者参考,本网站未对该内容进行证实,对其原创性、真实性、完整性、及时性不作任何保证。

3.文章转载时请保留本站内容来源地址,https://www.lu-xu.com/yule/1606841.html